第11回全脳アーキテクチャ勉強会 〜Deep Learning の中身に迫る〜

全脳アーキテクチャ勉強会における中心的なテーマであるDeep Learningについては,CaffeやChainerを始め開発環境が充実しつつありますが,全脳アーキテクチャのための新しいアーキテクチャを創出するためには,ゼロから多層複雑ネットワーク等を構築することも多いの想定されます.

そのためにも,Deep Learningの中身,例えば,中間層で起きていることや,なぜ,学習できるのか等を深く理解しておくことが重要です.そこで,今回の勉強会では,物理学や力学的解析の視点からのDeep Learningの中身に迫る講演2件と,世界初の商用レベルでサポートされたオープンソースディープラーニングフレームワークであるDeeplearnig4jを開発されたSkymind社CTOのAdam Gibson氏の講演を企画しました.

勉強会開催詳細

- 日 時:2015年8月26日(水) 18:00~21:00 (開場: 17:30~)

- 場 所:リクルートGINZA8ビル(G8) 11階大ホール

- (リクルート様のご厚意により会場提供していただきました)

- http://www.recruit.jp/company/about/office.html

- 定 員:200名(定員に達し次第締め切らせて頂きます)

- 参加費:無料

- 申込方法:本イベントに参加登録のうえ,当日会場受付にてお名前またはチケットをご提示下さい。

- 主 催:全脳アーキテクチャ・イニシアティブ

レポーターを募集しています

ドワンゴ人工知能研究所所長山川宏氏と共著にて本勉強会の報告書作成にご協力いただくレポーターを募集しております。報告書の分量は4000~7000字程度とし,ドワンゴ人工知能研究所のテクニカル・レポートとして発行する予定です。

ネット配信について

本勉強会は、ニコニコ生放送にて各講演者の講演と全体討論を配信しました。開催日より1週間、ニコニコ生放送にてご覧頂けます。

講演スケジュール

18:00 – 18:10「オープニング」(電気通信大学/ドワンゴ人工知能研究所 栗原聡 氏)

18:10 – 19:00「深層学習の学習過程における相転移」(京都大学大学院情報学研究科 大関真之 氏)

「深層学習の学習過程における相転移」(京都大学大学院情報学研究科 大関真之 氏)

深層学習で何が行われているのか理論的に理解する.しかし複雑なアーキテクチャを持つものであるためそれは非常に困難な道のりとは誰もが感じていることでしょう.本講演では、数理的なアプローチでその理解をしようとする取り組みについて講演します.そもそも論として、高次元の構造のあるデータを学習するときに教師なし学習と教師有り学習を素朴に行うとしたときに何が起こるのか.これを数理的な”おもちゃ”を使って調べてみます.高次元の極限を調べるために、原子分子などの非常に細かいものが集まった大きな数の世界を扱う手法に長けた理論を持つ物理学の手法を用いました.結果わかったことは、まず教師なし学習の量が多くなると、識別器の潜在的な能力が引き上げられることがわかります.しかし残念ながらその潜在的な能力を引き出すためには、生半可には超えられない壁があることがわかります.一方、教師有り学習の量を増やすと、その障壁が弱まること、あるところを境目にして高性能な識別器へと急激に変化することがわかりました.物理学の言葉では一次転移と呼ばれる現象に相当します.このようにまだまだ些細な進展ではありますが、ちょっと面白い発見について紹介させていただければと思います.

19:00 – 19:10 休憩

19:10 – 19:40「Deep Neural Networksの力学的解析」(東京大学総合文化研究科 本武陽一 氏)

「Deep Neural Networksの力学的解析」(東京大学総合文化研究科 本武陽一 氏)

近年の人工知能ブームのきっかけとなった技術的ブレークスルーであるDeep Learning技術ですが、その高いパフォーマンスが獲得される原因が、未だ明確ではありません。その原因は、Deep Neural Networksが非線形識別機であり、対象とするデータが高次元である為です。そこで私の研究では、そのような対象の解析に長じた、力学的解析手法によって、Deep Neural Networksの中で生じている現象を調べ、問題にアプローチしています。具体的には、Deep Neural Networksの各層を時刻ととらえ、その時間発展ダイナミクスの解析を通して、情報の圧縮や拡大等を議論しています。この解析の結果、「多様体仮説」と呼ばれる、実世界に存在する高次元データが、実はクラス(犬や猫といったラベルに対応)毎にそれぞれ別の低次元部分多様体上に分布しているという仮説が正しいようであることと、パフォーマンスの高い教師ありDeep Neural Networksが、それをうまく活用していることが分かってきました。講演では、Alexnet等の実践的なネットワークの解析結果を通して、上記のことを説明します。

19:40 – 19:50 休憩

19:50 – 20:30「SkymindのDeep Learningへの取り組み」(Skymind社CTO Adam Gibson氏)

「SkymindのDeep Learningへの取り組み」(Skymind社CTO Adam Gibson氏)

Gibsonによる,世界初の商用レベルでサポートされたオープンソースディープラーニングフレームワークであるDeeplearnig4jや,科学計算用のND4Jなど,Java仮想マシン向けのオープンソースライブラリについて解説する.

Adam Gibson 氏プロフィール:

Deeplenarnig OSSを提供するSkymind社を2014年にCTOとして起業。サンフランシスコのGalvanizeUにてデータサイエンティストマスタープログラムのアドバイザも務める。2015年秋に “Deep Learning: A Practitioner’s Approach”をO’reillyから刊行。

- 著書: O’Reilly’s Deep Learning: A Practitioner’s Approach (2015)

- アドバイザー: Zipfian, GalvanizeU のDeep Learning, データサイエンティストコース

- 登壇実績: Hadoop Summit, OSCon, Tech Planet, GigaOM

- 起業実績: 4x startup founder

- Deeplearning4j · GitHub

- Deeplearning4j – Open-source, distributed deep learning for the JVM

- Skymind – Deep learning for Industry on Hadoop and Spark

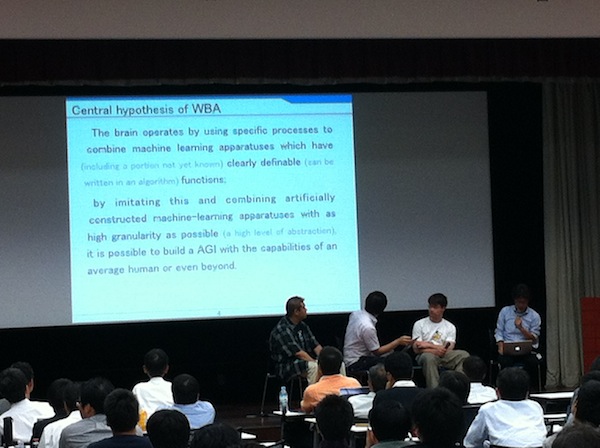

20:30 – 21:00 全体討論

日米のDeep learningの方法論や最新の動向について,Adam Gibson氏とドワンゴAIラボ所長山川氏との対談を中心とした全体討論を行いました。

21:00 – 23:00 懇親会(自由参加)

会場近辺のお店で、有志による懇親会を行いました。

ご講演ならびにご参加頂いたみなさま、どうもありがとうございました。

次回勉強会開催時にメールでお知らせします。

次回全脳アーキテクチャ勉強会開催のお知らせを希望される方は、下記にご登録をお願いします。

コミュニティメンバーになると、勉強会開催時にメールにてお知らせが届きます。

English

English